In questi anni abbiamo eseguito analisi SEO per i nostri clienti e per i nostri progetti. Grazie all’applicazione pratica e alla lettura di libri e approfondimenti dedicati alle analisi SEO (Search Engine Optimization), abbiamo creato un processo per fare una revisione dei siti e individuare i problemi.

Questa guida ti spiega proprio come fare una revisione SEO del tuo sito. Se, invece, vuoi conoscere i passi per un’ottimizzazione ti consigliamo di rivolgerti a un consulente SEO, in quel caso, infatti, ci sono diversi altri fattori da tenere in considerazione. Puoi dare anche un’occhiata ai nostri 100+ suggerimenti per l’ottimizzazione SEO di WordPress per farti un’idea di quanti fattori bisogni considerare.

Avere un sito ottimizzato ti aiuta a ottenere le prime posizioni sui motori di ricerca. Ottimizzare nella pratica significa far percepire a Google che il tuo sito è rilevante rispetto alle ricerche degli utenti.

Table of Contents

Preparazione per l’analisi SEO

Nonostante ci possa essere la voglia di sporcarsi subito le mani e passare alla fase operativa dell’analisi, come prima cosa è necessario preparare il terreno per le fasi successive del lavoro.

Crawling

Crawling è un termine usato per indicare il processo durante il quale gli spider del motore di ricerca “visitano” il tuo sito studiandone il contenuto per inserirlo nei loro indici.

Il primo passo che dobbiamo eseguire durante la nostra analisi consiste appunto nell’eseguire un crawl usando un tool, gratuito o a pagamento che sia. In questo modo sappiamo con cosa abbiamo a che fare, oltre ad avere una panoramica di eventuali errori o lacune del sito web.

Strumenti per il Crawling

Anche se è possibile creare il proprio strumento per il crawling in modo da ottenere un’analisi dettagliata che segua dei parametri custom, potrebbe non essere la scelta più semplice.

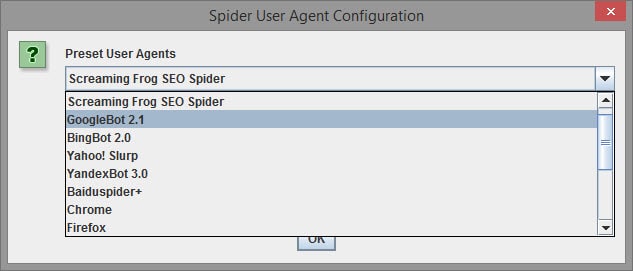

Noi ci appoggiamo sempre a Screaming Frog’s SEO Spider per eseguire il crawl.

Questo tool viene distribuito in modalità freemium, vale a dire che se il tuo sito ha meno di 500 pagine puoi usarlo gratuitamente, altrimenti il costo della versione completa è di 239€ all’anno.

Se devi eseguire questo tipo di analisi soltanto una volta per il tuo sito web che ha più di 500 pagine un’ottima soluzione è fare una ricerca su fiverr e farsi fare una scansione del sito web per pochi dollari.

Ti invieranno la scansione in formato excel e potrai consultarla ogni volta che sarà necessario.

In alternativa è possibile anche usare Xenu’s Link Sleuth. Tieni però presente che questo strumento è stato creato per cercare i link rotti (ovvero i link del tuo sito web che puntano ad una pagina che non esiste) e non per scopi SEO come Screaming Frog.

Puoi creare questo strumento per individuare title e meta description delle pagine, ma per un’analisi SEO approfondita come questa non è comunque sufficiente.

Configurazione del Crawl

Una volta che hai scelto il crawler che vuoi usare è necessario configurarlo in modo che si comporti come il motore di ricerca che ci interessa. Andiamo quindi ad impostare l’user agent per il crawler nel modo appropriato:

Googlebot - "Mozilla/5.0 (compatible; Googlebot/2.1; +https://www.google.com/bot.html)” Bingbot - "Mozilla/5.0 (compatible; bingbot/2.0; +https://www.bing.com/bingbot.htm)"

A questo punto dobbiamo impostare il crawler decidendo il suo “livello di intelligenza”.

C’è sempre stato un dibattito acceso relativamente all’intelligenza dei crawler.

Di fatto nessuno sa con certezza se questi tengono in considerazione i cookies, i JavaScript ed i CSS mentre eseguono la scansione di un sito. In pratica non sappiamo se assomigliano più ad un browser o ad un semplice script curl.

Il consiglio è di disabilitare cookies, JavaScript e CSS quando eseguiamo il crawling. In questo modo possiamo diagnosticare eventuali problemi rilevati dai crawler più semplici. Queste considerazioni saranno applicabili anche ai crawler più evoluti.

Search Console

Nonostante il crawling sia in grado di darci tante informazioni, è comunque necessario consultare direttamente i motori di ricerca.

Visto che gli algoritmi dei motori di ricerca non sono di libero accesso, possiamo utilizzare gli strumenti per webmaster.

La maggior parte dei motori di ricerca offrono un pannello per diagnosticare i vari problemi sul sito, nel nostro caso ci focalizzeremo su Google Search Console e Bing Webmaster Tools.

Analytics

A questo punto dobbiamo raccogliere informazioni direttamente dai nostri visitatori. Il miglior modo per farlo è usare uno strumento come Google Analytics.

Esistono numerose alternative allo strumento gratuito di Google, per i nostri scopi possiamo usare qualsiasi strumento, basta che ci permetta di tenere traccia delle visite sul sito ed identificare dei pattern.

Non abbiamo ancora finito di recuperare dati per la nostra analisi, ma siamo a buon punto. Iniziamo!

Accessibilità

È fondamentale che il tuo sito possa essere visto dai motori di ricerca e dai visitatori. Per questo, il primo passaggio di questa analisi SEO è verificare che tutte le pagine del tuo sito web siano accessibili.

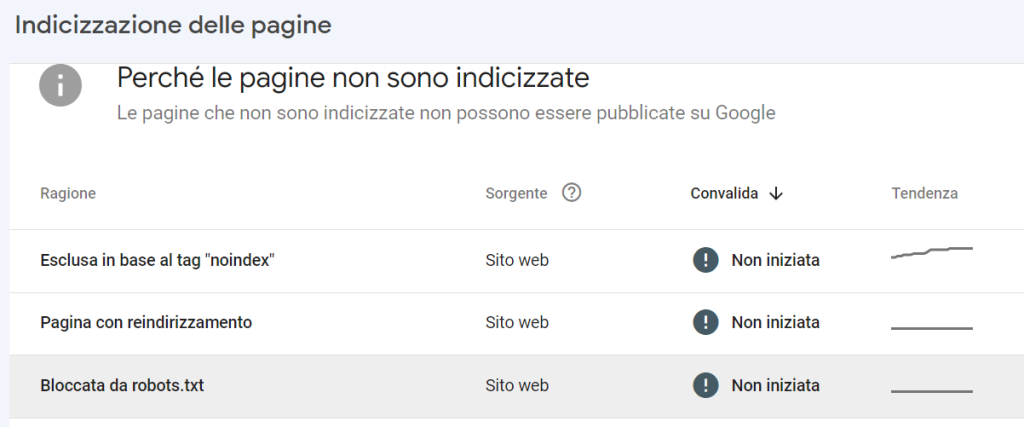

Robots.txt

Il file robots.txt viene usato per restringere l’accesso al crawler dei motori di ricerca ad alcune pagine o sezioni del tuo sito web. Nonostante sia molto utile, è possibile che inavvertitamente blocchi i crawlers che visitano (o vorrebbero visitare) il nostro sito web.

Alcuni motori di ricerca o strumenti di web scraping possono ignorare queste disposizioni, ma in genere Google e Bing rispettano le disposizioni indicate tramite questo file.

Ad esempio se il tuo file mostra il seguente testo, vuol dire che stai bloccando l’accesso a tutte le tue pagine che, di conseguenza, non saranno indicizzate.

User-agent: * Disallow: /

In questa prima fase è necessario controllare il tuo file robots.txt per assicurarci che il sito sia accessibile e che non stiamo tagliando fuori sezioni importanti del nostro sito web. È possibile controllare tramite Google Search Console quali pagine sono bloccate ai motori di ricerca.

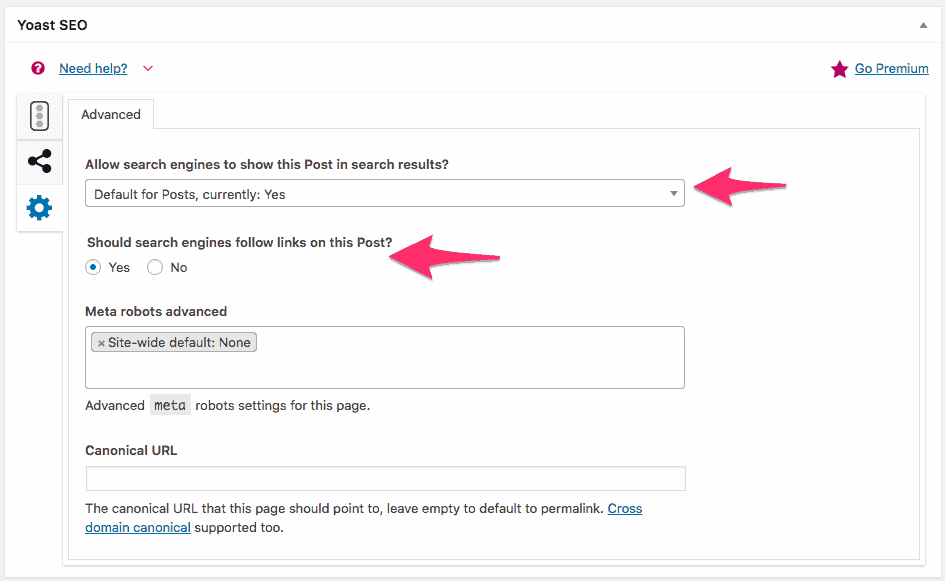

Robots Meta Tags

Il meta tag robots è usato per indicare al crawler come comportarsi su quella pagina specifica. Usando questo tag possiamo dirgli se indicizzare o meno una pagina e se seguire o meno i link in essa contenuti.

Ci sono diversi metodi per impostare il meta tag robots. Se hai un sito WordPress puoi usare il plugin Yoast SEO che ti permette di impostare il tag per le singole pagine.

Mentre analizziamo l’accessibilità del nostro sito web durante una analisi seo, vogliamo assicurarci che nessuna pagina che vogliamo indicizzare sia impostata su noindex.

Per esempio una pagina che presenta questo codice all’interno dell’header non sarà mostrata sui motori di ricerca ed i link al suo interno non saranno seguiti dal crawler:

<meta name="robots" content="noindex, nofollow" />

Decidere quali pagine far indicizzare e quali no può rappresentare una scelta più o meno complessa.

Come regola generale possiamo dire che tutte le pagine del sito dovrebbero essere indicizzate ad eccezione delle pagine legali (privacy policy, termini di servizio) che dovrebbero essere impostate come “noindex, follow”.

Ovviamente questo non è sempre vero e va valutato di caso in caso a seconda delle necessità.

Codici di stato HTTP

I motori di ricerca come gli utenti non saranno in grado di visitare il tuo sito web se questo restituisce degli errori, come ad esempio errori 4xx (tra cui l’errore 403 e l’errore 404) o 5xx. Questi alert vengono chiamati codici di stato http.

Durante il crawl dovresti identificare tutte le pagine che restituiscono un errore, con particolare attenzione agli errori soft 404.

Nel caso in cui una di queste pagine non sia più disponibile, si renderà necessario impostare un redirect 301 verso una pagina con un contenuto simile o rilevante.

Redirects

Un redirect o rinvio è una pagina che contiene un rimando automatico a un’altra pagina.

Wikipedia

È bene controllare tutti i reindirizzamenti per verificare che siano redirect 301.

Bisogna evitare i redirect 302, JavaScript redirect e meta refresh redirect perché questi non passano link juice alla pagina di destinazione.

Sitemap XML

La sitemap XML è una mappa che i motori di ricerca usano per trovare con facilità tutti i contenuti presenti sul tuo sito web. Durante una analisi SEO, quando analizziamo la sitemap è necessario rispondere a queste domande:

- Hai inviato la sitemap attraverso la Search Console? Anche se i motori di ricerca individuano da soli la sitemap, spesso è meglio inviarla direttamente.

- La tua sitemap è un file XML con la giusta sintassi? Segue alla lettera il protocollo delle sitemap? I motori di ricerca si aspettano un formato specifico per la sitemap di un sito web, in caso contrario potrebbero non processarla in modo corretto.

- Hai trovato pagine tramite il crawl che non sono presenti nella sitemap? Assicurati che la tua sitemap sia sempre aggiornata.

- Ci sono pagine indicate nella sitemap che non sono state trovate tramite il crawl? Se sì, ti presento le pagine orfane, ovvero pagine che non hanno alcun link all’interno del tuo sito web. Trova il posto appropriato ed inserisci un link a contenuti del tuo sito per assicurarti che abbiano almeno un backlink interno.

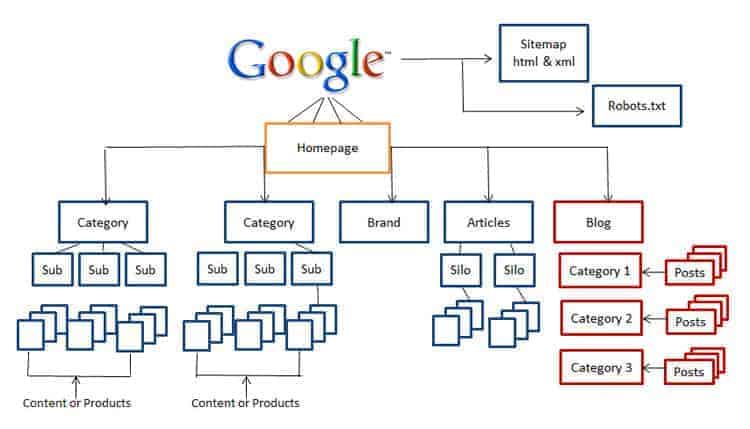

Architettura del sito web

L’architettura del tuo sito web definisce la struttura del tuo sito web, ovvero la sua profondità in verticale e la sua larghezza in orizzontale.

Valuta quanti click sono richiesti per arrivare alle tua pagine più importanti, cercando un equilibrio tra i livelli orizzontali ed i livelli verticali.

Elementi Flash e JavaScript

Alcuni elementi sono inaccessibili ai crawler. Nonostante recentemente tutti i menu, anche quelli più complessi, sono creati usando soltanto il CSS, è possibile vedere dei siti i cui menu sono creati in flash o JavaScript.

Nonostante i motori di ricerca siano diventati più intelligenti col passare degli anni, la scelta più sicura è sempre quella di evitare questo tipo di elementi, specialmente nel caso dei menu. Se il crawler non è in grado di “vedere” il menu non seguirà i link e non comprenderà l’architettura del tuo sito web.

Se vuoi valutare la navigabilità del tuo sito puoi eseguire due scansioni: una con i JavaScript attivati ed una con i JavaScript disattivati. In questo modo semplicemente comparando i risultati potrai identificare le sezioni che sono inaccessibili senza l’utilizzo di JavaScript.

Performance del sito web

È risaputo che gli utenti online hanno una soglia di attenzione molto bassa, e se la pagina impiega più di 2 secondi per il caricamento completo puoi star certo che lasceranno il tuo sito per non tornare mai più.

Allo stesso modo Google premia i siti veloci, dal momento che offrono una migliore esperienza per l’utente. E sappiamo con certezza che il principale focus di Google è proprio la user experience.

Inoltre il tempo a disposizione dei crawler è limitato, ed il numero di siti web sempre crescente. Va da sé che se nello stesso lasso di tempo il crawler è in grado di indicizzare un maggior numero di pagine effettuerà una scansione più approfondita (scansionando quindi un maggior numero di pagine).

Puoi controllare la velocità de tuo sito web usando diversi strumenti. Abbiamo scritto una guida relativa all’ottimizzazione del tuo sito web che tratta a fondo l’argomento velocità e prestazioni per WordPress.

Indicizzabilità

Grazie a questo primo passaggio dell’analisi SEO abbiamo visto come capire quali sono le pagine accessibili ai motori di ricerca. Ora è il momento di scoprire quali di queste pagine sono state indicizzate.

Il comando “site:”

Quasi tutti i motori di ricerca hanno il comando “site:”, un operatore di ricerca avanzata che ti permette di eseguire una ricerca dei contenuti di un sito web specifico. Questo tipo di ricerca ci fornisce una stima del numero di pagine indicizzate dal motore su cui eseguiamo la ricerca.

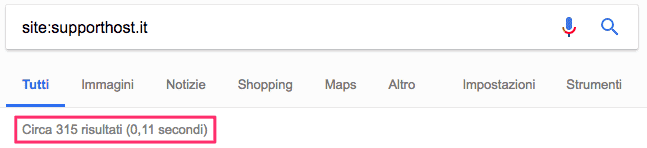

Ad esempio se cerchiamo “site:supporthost.it” vediamo che ci sono 315 pagine indicizzate:

Questo numero di pagine indicizzate non è accurato, ma ci è comunque utile per avere una stima (chiameremo questo valore index count). Conosci già il numero delle pagine del tuo sito grazie al crawl che abbiamo fatto ed alla sitemap XML (chiameremo questo numero conteggio) e saremo quindi in un uno di questi scenari:

- L’index count ed il conteggio tramite crawl e sitemap sono più o meno equivalenti. Questo è lo scenario ideale dal momento che il motore di ricerca ha indicizzato tutte le pagine del tuo sito web.

- L’index count è superiore rispetto al conteggio. In questo caso è molto probabile che il tuo sito abbia del contenuto duplicato.

- L’index count è inferiore rispetto al conteggio. Questo indica che i motori di ricerca non indicizzano molte delle pagine del tuo sito web. Probabilmente hai già identificato questo nel passaggio precedente. In caso contrario devi controllare se il tuo sito web è stato penalizzato.

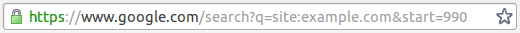

Se hai il sospetto che il tuo sito web abbia dei contenuti duplicati, esegui nuovamente la ricerca col comando “site:” ed aggiungi “&start=990” alla fine dell’url nel browser:

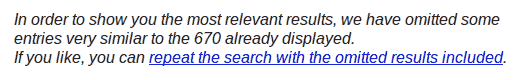

A questo punto controlla se Google ti mostra un messaggio che indica che ci sono contenuti duplicati come questo:

Se hai un problema coi contenuti duplicati non disperare, vedremo come risolverlo nella prossima sezione della nostra revisione SEO.

Controllo della bontà dell’indicizzazione

Scendiamo adesso in maggiori dettagli per la nostra analisi SEO. Vediamo se e come i motori di ricerca indicizzano le nostre pagine più importanti.

Quando effettuiamo la ricerca con l’operatore “site:” i risultati dovrebbero essere mostrati in ordine di importanza. Questo significa che il primo risultato dovrebbe corrispondere all’home page del sito. Se non è così può dipendere da due problemi:

- È necessario rivedere l’architettura del tuo sito web in modo da dare più importanza alle pagine che devono stare più in alto;

- È possibile che la pagina non sia completamente mostrata nei risultati di ricerca.

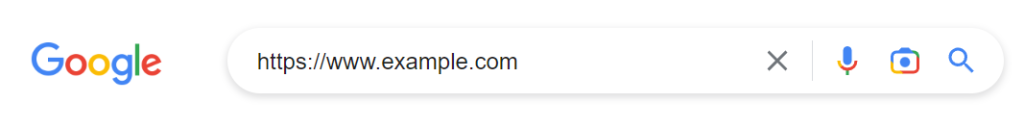

Ricerche di pagina

Per capire se una determinata pagina è inclusa nell’indice, puoi fare una ricerca per quella singola pagina, così:

Se non trovi la pagina nell’indice del motore di ricerca, controlla che sia accessibile. Se è accessibile assicurati di non aver ricevuto penalizzazioni.

Ricerche di brand

Dopo aver controllato che le tue pagine siano indicizzate, devi controllare che il tuo sito sia ben posizionato se fai una ricerca col tuo brand.

Fai una ricerca per il nome del tuo brand o della tua attività. Normalmente il tuo sito dovrebbe apparire in cima ai risultati. Se il tuo sito non è proprio presente potrebbe essere stato penalizzato, vediamo come investigare ulteriormente.

Penalizzazioni sui motori di ricerca

Mi auguro che sei arrivato fino a questo punto delle revisione SEO del tuo sito web senza aver trovato niente che possa far pensare ad una penalizzazione. Ma se credi che il tuo sito abbia subito una penalizzazione ecco quattro passi da seguire per risolvere.

1. Assicurati di essere stato penalizzato

Spesso e volentieri succede che quella che si pensava fosse una penalizzazione altro non era che un errore (ad esempio un tag noindex inserito inavvertitamente). Quindi prima di correre ai ripari assicuriamoci che si tratti realmente di una penalizzazione.

Nella maggior parte dei casi una penalizzazione sarà ovvia. Potresti aver ricevuto una notifica tramite Search Console. Oppure la tua pagina non è nell’indice nonostante sia normalmente accessibile.

È anche importante notare che il tuo sito potrebbe aver semplicemente perso del traffico a causa di un aggiornamento dell’algoritmo di Google, aggiornamenti che si fanno sempre più frequenti e talvolta catastrofici per alcuni siti. Nonostante questa non sia una vera e propria penalizzazione dovrebbe essere gestita come tale.

2. Identifica il motivo della penalizzazione

Se sei sicuro che il tuo sito ha subito una penalizzazione, devi capire quali sono stati i motivi. Nel caso in cui hai ricevuto un avvertimento attraverso la Search Console, ti saranno state spiegate anche le motivazioni.

Se il tuo sito è stato vittima di un aggiornamento dell’algoritmo, la situazione sarà certamente più complessa. Dovrai ricercare in rete informazioni relative all’aggiornamento fino a trovare la soluzione.

Quando ci sono aggiornamenti dell’algoritmo che hanno un impatto su diversi siti, ci saranno discussioni su blog, forum e gruppi Facebook di settore che ti aiuteranno a capire la causa della penalizzazione.

Se invece il problema risiede nella presenza di backlink dannosi o non naturali verso il tuo sito, potresti risolvere con facilità utilizzando lo strumento di disavow di Search Console.

3. Sistema il problema che ha portato alla penalizzazione

Una volta identificato il motivo della penalizzazione, sistemare la causa che ha generato il problema sarà sicuramente facile.

4. Richiedi una riconsiderazione

Dopo che hai sistemato dovrai richiedere una riconsiderazione al motore di ricerca che ti ha penalizzato. Tieni presente che se il tuo sito era soltanto vittima di un upgrade dell’algoritmo questo tipo di richiesta sarà completamente inutile e dovrai semplicemente aspettare.

Per maggiori informazioni leggi la guida di Google per le riconsiderazioni.

SEO On Page

Adesso spostiamoci verso un altro aspetto della SEO del tuo sito web. Le caratteristiche del tuo sito web che influenzano il posizionamento.

Le attività on page sono tutte quelle che possiamo svolgere direttamente sul nostro sito web.

URLs

Quando eseguiamo una analisi SEO di un sito web analizzandone le URL dobbiamo farci alcune domande:

- L’URL è corta e leggibile? Una buona regola sarebbe mantenere le URL di una lunghezza inferiore a 115 caratteri.

- L’URL include parole chiave rilevanti? È importante usare una URL che descrive il suo contenuto.

- L’URL sta usando sottocartelle invece di sottodomini? I sottodomini sono utilizzati come domini unici dai motori di ricerca quando si tratta di passare la link juice.

- L’URL usa dei parametri dinamici? Quando possibile usa solo URL statiche. Se non puoi evitare di usare parametri dinamici, assicurati di registrarli sulla Search Console.

- L’URL usa il segno meno (“-“) per separare le parole? Il segno underscore (“_”) non era ben visto in passato da certi motori di ricerca. Per dormire sonni tranquilli usa il segno meno per separare le parole nell’URL.

Analizzando le URLs per un intero dominio dobbiamo farci invece le seguenti domande:

- La maggior parte delle URLs seguono i punti elencati qui sopra? O sono mal-ottimizzate?

- Basandoci sulla ricerca di parole chiave trattate dal nostro sito il nome del dominio è appropriato? Contiene le keywords? Sembra spam?

Contenuti duplicati con URL differenti

Durante la nostra analisi SEO, oltre a controllare l’ottimizzazione delle URL è importante notare se ci sono dei contenuti duplicati causati proprio dalle URL.

Le URL sono quasi sempre le responsabili per i contenuti duplicati. Se due diverse URL mostrano lo stesso contenuto il motore di ricerca crede che queste siano due pagine diverse.

Il confronto fra l’index count ed il conteggio che abbiamo indicato prima dovrebbe darti un’idea rispetto ai contenuti duplicati sul tuo sito web.

Per maggiore scrupolo puoi controllare anche che non ci siano errori che generano problemi di contenuti duplicati con le URL.

Quando tratteremo l’analisi del contenuto vedremo dei sistemi pratici per trovare le duplicazioni.

Contenuto

Spesso di dice “content is king”. Vediamo quindi di trattarlo come si merita.

Per investigare il contenuto di una pagina abbiamo diversi strumenti a disposizione. Il più semplice da usare è la Google cache che ci permette di vedere una versione solo testo della nostra pagina.

In alternativa puoi usare anche SEO Browser o Browseo. Questi due browser ci mostrano una versione solo testo della nostra pagina web ed includono anche altri dati interessanti relativi alla pagina come il page title e la meta description fra gli altri.

Indipendentemente dallo strumento che decidi di usare sarà necessario trovare una risposta alle seguenti domande:

- La pagina contiene abbastanza contenuto? Non c’è una regola sulla lunghezza dei testi, ma Google raccomanda di inserire informazioni esaustive.

- Il contenuto ha un valore per chi lo legge? Questo è ovviamente una valutazione soggettiva, ma possiamo ottenere dei valori controllando il bounce rate e il tempo speso sulla pagina controllando le analytics.

- Il tuo contenuto contiene le parole chiave per cui vuoi posizionarti? Queste parole chiave compaiono nel primo paragrafo? Se vuoi posizionarti per una parola chiave devi assicurarti che sia presente nel contenuto.

- Il tuo contenuto sembra spam? Hai esagerato con la keyword density, ovvero hai ripetuto troppe volte la tua parola chiave al punto da rendere pesante la lettura?

- Ci sono errori di battitura o errori grammaticali? Se non vuoi perdere di credibilità assicurati di controllare il tuo testo per evitare errori.

- Il contenuto è facilmente leggibile? Esistono varie metriche per stimare la leggibilità del tuo contenuto come ad esempio Flesch Reading Ease, Fog Index. Questi indici però sono studiati per la lingua inglese e non funzionano altrettanto bene con l’italiano.

- I motori di ricerca sono in grado di controllare il tuo contenuto? Se il tuo contenuto è dentro flash, o se si tratta di testo all’interno di una immagine o di JavaScript troppo complesso, i motori di ricerca potrebbero non essere in grado di vedere il contenuto della tua pagina.

Durante l’analisi del tuo contenuto ci focalizzeremo su 3 aree principali:

- architettura del sito,

- cannibalismo,

- contenuti duplicati.

1. Architettura delle informazioni

L’architettura del tuo sito web definisce come le informazioni vengono presentate sul sito. Durante questa fase dovresti assicurarti che ogni pagina del tuo sito abbia un obiettivo ben preciso. Dovresti anche verificare che ogni keyword che ti interessa sia rappresentata da una pagina del tuo sito web.

2. Cannibalismo

Si definisce cannibalismo delle parole chiave quando più di una pagina usa la stessa parola chiave per cercare di posizionarsi. Quando più di una pagina usa la stessa keyword si crea confusione per il motore di ricerca e crea confusione per gli utenti.

Per identificare il cannibalismo puoi creare un indice delle keyword per mappare tutte le pagine del tuo sito web. Una volta identificate le pagine che usano la stessa keyword puoi unire le pagine o modificarne una delle due in modo da posizionare una di queste per una keyword differente.

3. Contenuto duplicato

Il tuo sito presenta del contenuto duplicato quando presenta più pagine con lo stesso contenuto o con contenuto similare. Questo tipo di problema può accadere sia tra pagine dello stesso sito che tra siti diversi.

Per trovare contenuti duplicati all’interno del tuo sito puoi usare questo tool: Siteliner.

Se vuoi verificare che sul tuo sito non ci siano contenuti duplicati già presenti su altri siti puoi utilizzare Copyscape.

HTML Markup

Il codice HTML delle tue pagine contiene gli elementi più importanti per il SEO, è quindi necessario controllare che il tuo codice sia valido per gli standard W3C.

W3C offre un servizio per validare il tuo codice HTML ed un servizio per validare i tuoi CSS per aiutarti a controllare il tuo sito web.

Title

Il title è la parte più identificativa della pagina. È il titolo che compare nei motori di ricerca, quello che vedi in alto nella scheda del browser e la cosa che le persone notano nei social media. Ecco perché è importante controllare i title del tuo sito web.

Mentre controlli il titolo devi farti le seguenti domande:

- Il title è breve abbastanza? È buona pratica mantenere la lunghezza del title inferiore ai 70 caratteri. Un title più lungo sarà tagliato dai motori di ricerca e rende difficile alle persone fare dei commenti su twitter.

- Il title descrive il contenuto della pagina? Evita di usare un titolo clickbait che in realtà non descrive il contenuto se non vuoi vedere il bounce rate schizzare alle stelle.

- Il title contiene la parola chiave per cui vuoi posizionarti? È buona norma usare la parola chiave per cui vuoi posizionarti nel title della tua pagina, ed usarla all’inizio di questo. Questa è l’ottimizzazione SEO on-page più importante.

- Il tuo title è sovraottimizzato? Cerca di scrivere il title per i tuoi utenti, non per i motori di ricerca, e soprattutto evita il keyword stuffing.

Assicurati che ogni pagina abbia un title unico, puoi usare il crawl per effettuare questa analisi.

Meta Description

La meta description non viene usata più dai motori di ricerca come fattore di ranking, ma influisce indirettamente dal momento che influenza il CTR (la percentuale di persone che cliccano sul tuo risultato dopo averlo visto).

Le domande da farsi per quanto riguarda la meta description sono le stesse del title indicate sopra. È necessario mantenere la lunghezza inferiore a 155 caratteri ed evitare di sovra-ottimizzare il testo.

Anche la meta description deve essere unica per ogni pagina. Per capire se ci sono duplicati puoi usare il crawl.

Altri Tag <head>

I tag title e description sono senza dubbio i più importanti dal punto di vista SEO all’interno della sezione <head>. Facciamo un controllo ulteriore:

- Qualcuna delle tue pagine usa il campo meta keyword? Nel tempo questo campo è stato associato allo spam, per stare sicuri conviene evitare di usarlo completamente.

- Stai usando il link rel=“canonical” in qualcuna delle tue pagine? Se lo stai usando assicurati di farlo in modo corretto per evitare il problema dei contenuti duplicati.

- Hai dei contenuti divisi su diverse pagine? Stai usando correttamente i rel=”prev” e rel=”next”? Aggiungere questi parametri ai link aiuta i motori di ricerca ad identificare la paginazione sul tuo sito web.

Immagini

Un foto vale 1000 parole, ma non per i motori di ricerca. Per questo motivo dobbiamo usare i metadati in modo da dare maggiori informazioni ai motori di ricerca.

Quando si analizza un’immagine da un punto di vista SEO la parte più importante sono il nome del file e l’alt text. Entrambi i testi dovrebbero descrivere l’immagine e dove possibile contenere la parola chiave per cui vuoi posizionarti. Se vuoi approfondire l’argomento controlla il nostro articolo su come ottimizzare le immagini per la SEO in cui spiego anche come prelevare in automatico gli attributi delle immagini che carichi su WordPress.

Link in uscita

Quando una pagina linka un’altra, la pagina che riceve il link è come se ricevesse un voto. Per questo è importante assicurarsi che i link in uscita siano di qualità.

Inserire un link verso un sito di bassa qualità o un sito considerato spam può indicare che anche il tuo sito sia di bassa qualità.

Per valutare i link durante la analisi SEO è opportuno farsi le seguenti domande:

- I link puntano ad un sito affidabile? Come detto sopra se dal tuo sito mandi dei link verso un sito di spam, Google potrebbe arrivare alla conclusione che anche il tuo è un sito di spam.

- I link sono rilevanti rispetto al contenuto della pagina? I link nella tua pagina dovrebbero rimandare a risorse utili o contenuti rilevanti. Se aggiungi un link verso una pagina che non ha alcuna rilevanza con l’argomento trattato dalla tua pagina peggiora l’esperienza dell’utente e riduce la rilevanza della tua pagina rispetto all’argomento trattato agli occhi di Google.

- I link nella pagina usano un anchor text rilevante? L’anchor text usa keywords rilevanti? L’anchor text di un link dovrebbe essere descrittivo. Questo aiuta gli utenti a capire se vogliono cliccare sul link ad al motore di ricerca a capire di cosa tratta la pagina di destinazione.

- Qualcuno dei link è rotto? Se cliccando sul link si riceve un errore 4xx o 5xx, il link è considerato rotto. Puoi trovare i link rotti tramite il crawl o tramite un Link Checker.

- I tuoi link usano dei redirect inutili? Se i tuoi link interni eseguono un redirect stai diluendo la link juice che passa da una pagina all’altra del tuo sito web. Assicurati che i tuoi link interni rimandino alle pagine corrette.

Quando controlli i link del tuo sito web dovresti verificare la distribuzione dei tuoi link in modo che le pagine più importanti siano quelle che ricevono più link.

Stai attento a non creare una situazione identificabile come rank sculpting, ma allo stesso tempo devi dare maggiore importanza alle pagine principali del tuo sito web.

Altri Tag <Body>

Oltre alle immagini ed i link, ci sono altri elementi importanti che possiamo trovare nella sezione <body> della tua pagina web durante la revisione SEO. Ecco le domande che dobbiamo farci durante l’analisi:

- La pagina contiene un titolo <h1>? Questo contiene una delle parole chiave per cui vuoi posizionarti? I titoli sono sono importanti come il tag title ma hanno comunque una rilevanza e dovrebbe contenere la parola chiave per cui vuoi posizionarti. Leggi come usare i tag header.

- La pagina usa frames o iframes? Se stai usando un frame per mostrare del contenuto i motori di ricerca non associano quel contenuto alla tua pagina.

- Rapporto tra contenuto e pubblicità. Assicurati che il contenuto non venga sommerso dalle pubblicità.

SEO Off Page

I parametri SEO on-page sono senza dubbio una parte importante nella nostra analisi, ma è necessario eseguire anche un approfondito controllo del SEO off-page.

Le attività off page sono tutte quelle svolte su elementi esterni rispetto al nostro sito web.

Popolarità

Anche se i siti più popolari non sono i più utili, non possiamo ignorare questo parametro: il successo di un sito web. Quando si valuta la popolarità di un sito web dobbiamo rispondere ad alcune domande:

- Il tuo sito è in crescita? Semplicemente controllando le tue analytics puoi vedere se stai guadagnando o perdendo traffico rispetto ai mesi/settimane precedenti.

- Quale è la tua popolarità comparata con altri siti simili? Puoi usare servizi di terze parti come Alexa, Quantcast o SimilarWeb per valutare la situazione.

- Ricevi backlinks da siti popolari? Puoi usare uno strumento per controllare la popolarità del tuo sito usando una metrica basata sui link come mozRank per valutare la tua popolarità e quella dei siti che ti linkano.

Affidabilità

L’affidabilità di un sito web è un parametro molto soggettivo dal momento che ognuno ha la propria interpretazione e il proprio concetto per questo termine. Per evitare dei pregiudizi personali è necessario usare dei parametri che sono considerati globalmente come non affidabili.

I comportamenti non affidabili possono essere divisi in varie categorie, ma nel caso della nostra analisi SEO ci focalizzeremo su malware e spam. Per controllare il tuo sito puoi affidarti a delle blacklist come DNS-BH o le API di Google. Potresti voler usare uno strumento come SiteAdvisor.

Se vuoi assicurarti che il tuo non sia considerato un sito di spam da parte di Google, ci sono delle verifiche da fare:

- Keyword Stuffing – consiste nella creazione di un contenuto con una keyword density troppo alta.

- Testo nascosto o invisibile – usare le differenze delle tecnologie dei browser e degli spider per nascondere del testo agli utenti e mostrarlo agli spider. Solitamente viene fatto mostrando del testo con lo stesso colore dello sfondo.

- Cloaking – far vedere versioni differenti della stessa pagina agli utenti ed ai motori di ricerca, solitamente viene fatto sfruttando gli IP o l’user agent.

Anche se il tuo sito risulta affidabile, è necessario controllare l’affidabilità dei vicini, ovvero dei siti che linkano al tuo sito e che vengono linkati dal tuo sito.

Profilo backlink

La qualità del tuo sito è definita dalla qualità dei siti che lo linkano. Per questo motivo è molto importante analizzare il profilo backlink e vedere come è possibile migliorarlo.

Esistono una serie di strumenti creati proprio a questo scopo tra cui Search Console, Open Site Explorer, Majestic SEO, e Ahrefs.

Ecco cosa controllare relativamente ai tuoi backlinks:

- Quanti domini unici linkano al tuo sito web? Quanti più link meglio è, ma avere 100 link da 100 domini differenti ha molto più valore che avere 100 link dallo stesso dominio.

- Che percentuale dei backlink sono nofollow? Idealmente la maggior parte dei backlink saranno dofollow, ma tieni presente che un sito che non ha backlink nofollow è sospetto.

- La distribuzione degli anchor text sembra essere naturale? Se troppi backlink usano un “exact match anchor text” i motori di ricerca avranno il sospetto che quei backlink non siano naturali.

- I backlink ti arrivano da siti a tema? Se i link verso il tuo sito sono presenti su siti sullo stesso tema questo aiuta a far vedere il tuo sito come autorevole per quell’argomento.

- Quanto sono popolari, degni di fiducia e che autorità hanno i siti che ti linkano? Se sei linkato da troppi siti di bassa qualità anche tu sarai considerato di bassa qualità.

Autorità

L’autorità di un sito web è definita da una combinazione di fattori come la qualità e quantità dei backlinks, la sua popolarità e la sua affidabilità.

Per stimare l’autorità del tuo sito web SEOmoz ci fornisce due metriche molto importanti: la Page Authority e la Domain Authority. La Page Authority ci aiuta a capire quanto in alto la pagina arriverà sui motori di ricerca mentre la Domain Authority si riferisce all’intero sito web.

Queste due metriche aggregano diverse metriche link (mozRank e moztrust fra le altre) per darti un semplice parametro per comparare la forza di una pagina o di un dominio.

Analisi della competizione

Adesso che hai finito la analisi SEO del tuo sito web, è giunto il momento di iniziare la stessa analisi per i tuoi competitor. È un lungo lavoro, ma una conoscenza approfondita dei tuoi competitor ti permetterà di capire cosa stanno facendo in più rispetto a te, e quali sono i loro punti deboli, in modo da poterli battere nel lungo periodo.

Seo Report

Una volta che hai terminato la analisi SEO del tuo sito e quello dei tuoi competitor è opportuno inserire tutte le tue osservazioni in un report che chiunque possa seguire per compiere i passi necessari per migliorare il sito web analizzato.

Se il tuo report dovrà essere condiviso con esecutivi e manager o chiunque non sia un tecnico, è bene inserire anche informazioni aggiuntive per renderlo comprensibile a tutti.

Inserisci delle priorità in modo da eseguire per prime le azioni più importanti, quelle che avranno un maggior impatto sul ranking del sito web, e lasciare le cose meno importanti e le rifiniture alla fine.

Cerca di essere specifico e dare dei consigli che possano essere usati come linee guida per le future operazioni. Indicare una cosa come “scrivi dei titoli migliori” ha poco senso in quanto generico.

Glossario

Anchor Text: il testo cliccabile in un link, quello che viene visualizzato dell’utente come sottolineato e che dà un’idea del tipo di contenuto che troveremo nella pagina di destinazione.

Backlink: un link che da un sito esterno rimanda al nostro sito web.

Keyword: letteralmente “parola chiave” per cui vuoi posizionare il tuo sito su Google. Di solito è costituita da più di una parola, chiamata anche keyphrase.

Keyword Density: la percentuale di parole chiave sull’intero testo. Solitamente si cerca di mantenere questi valore tra 1-2%.

Keyword Stuffing: l’utilizzo di una parola chiave un numero eccessivo di volte fino a rendere il testo poco scorrevole. Questa pratica viene penalizzata dai motori di ricerca.

Link Juice: indica la sommatoria dei tre valori passati tramite link da un documento all’altro: tematizzazione, pagerank, autorevolezza.

Malware: applicazioni che presentano un comportamento molesto, indesiderabile o nascosto.

Rank Sculpting: pratica volta a dare più importanza a pagine specifiche sistemando i link interni in modo da dare un maggior numero di link alle pagine del nostro sito che vogliamo far comparire più in alto rispetto alle atre pagine del sito web.

SERP: Search Engine Results Page ovvero la pagina dei risultati del motore di ricerca. È necessario avere contenuti di qualità sul nostro sito web se vogliamo migliorarne il posizionamento fino a raggiungere la prima pagina.

Spam: invio massivo di email indesiderate. Un sito di spam è un sito senza un valore per l’utente volto a dare link a certi siti per farli salire nelle SERP.

User Agent: in informatica lo user agent è un’applicazione installata sul computer dell’utente che si connette ad un processo server. Esempi di user agent sono i browser web, i lettori multimediali, i crawler e i programmi client mail.

Conclusioni

In questa guida ti ho mostrato come fare una revisione SEO del tuo sito. Senza dubbio ci sono molti controlli da fare: è bene assicurarsi per prima cosa che il sito sia accessibile, per poi controllare se è stato indicizzato.

Abbiamo parlato delle verifiche da fare direttamente sul sito (la SEO on page) e degli elementi esterni (la SEO off page). Al termine di questa guida puoi trovare un glossario con definizioni semplici dei termini e delle abbreviazioni usate.

Sei riuscito a fare un’analisi SEO del sito seguendo questa guida? Che miglioramento hai avuto? Lascia un commento per farcelo sapere.

Ultimo aggiornamento con indicazioni utili su come analizzare il sito web il 10 marzo 2023.

Lascia un commento