Ogni volta che digitiamo una query su Google, riceviamo una lista ordinata di risultati pertinenti in pochi secondi. Ma ti sei mai chiesto come fanno i motori di ricerca a conoscere l’esistenza di miliardi di pagine web? Alla base di questo processo ci sono i crawler, anche noti come spider o bot, programmi automatici che scandagliano in continuazione il web.

In questa guida approfondiremo nel dettaglio cosa sono i crawler, come funzionano, quale ruolo svolgono nella SEO e cosa possiamo fare per ottimizzare i nostri siti affinché vengano scansionati correttamente. Si tratta di un argomento fondamentale per chi gestisce un sito web, un blog, un e-commerce o lavora nel settore digitale.

Table of Contents

Cos’è un crawler?

Un crawler (termine che deriva dall’inglese to crawl, ovvero “strisciare”) è un programma automatizzato utilizzato dai motori di ricerca per scoprire e raccogliere informazioni sui contenuti presenti sul web. È anche conosciuto come spider, bot o web robot.

Questi software automatizzati operano in background, navigando di pagina in pagina seguendo i link presenti all’interno dei siti web. Il loro compito principale è quello di analizzare le informazioni contenute nelle pagine, inviarle al motore di ricerca e contribuire alla creazione dell’indice, una sorta di archivio gigantesco da cui il motore di ricerca attinge per restituire i risultati agli utenti.

Come funziona un crawler?

Il crawler parte da una lista di URL conosciute (ad esempio, inviate tramite sitemap o già presenti nel suo database) e inizia a visitarle. Ogni pagina viene esaminata (crawling) per rilevare i contenuti testuali, le immagini, i link interni ed esterni, i meta tag e altri elementi utili. Il crawler segue inoltre i link trovati nella pagina per scoprire nuovi URL da visitare connesse all’URL analizzato.

A questo punto le informazioni raccolte vengono inviate al sistema di indicizzazione del motore di ricerca, che le analizzerà ulteriormente per decidere se e come mostrarle nei risultati (indexing).

La scansione non è un processo unico: i crawler tornano periodicamente sui siti per verificare se ci sono stati aggiornamenti, nuove pagine o contenuti modificati. Il comportamento dei crawler è regolato da algoritmi molto complessi che determinano quanto spesso tornare su una pagina, quali URL hanno priorità rispetto ad altri, e quali sono i contenuti da ignorare.

Questi algoritmi tengono conto di vari fattori, tra cui la frequenza di aggiornamento del sito, l’autorevolezza del dominio, la presenza di errori tecnici e il numero di link che puntano a una determinata pagina.

Differenza tra crawling e indicizzazione

Due concetti spesso confusi sono crawling e indicizzazione: sono entrambi connessi al mondo dei motori di ricerca e di come gestiscono i contenuti sul web, ma non sono affatto due sinonimi. Il crawling è l’attività di esplorazione del web da parte dei bot, con l’obiettivo di scoprire nuovi contenuti; l’indicizzazione (o indexing), invece, è il processo successivo in cui i contenuti scoperti vengono analizzati e memorizzati nell’indice del motore di ricerca.

Una pagina può essere crawled ma non necessariamente indicizzata. Questo accade, ad esempio, se la qualità dei contenuti è scarsa, se la pagina è duplicata, o se ci sono istruzioni che impediscono l’indicizzazione (come il meta tag noindex o una regola nel file robots.txt).

Per chi si occupa di SEO, è fondamentale assicurarsi che le pagine importanti siano sia scansionabili sia indicizzabili.

Tipi di crawler

I crawler non sono tutti uguali: esistono diverse tipologie, ognuna sviluppata con obiettivi specifici. Conoscere le differenze tra questi strumenti automatizzati aiuta a capire meglio il loro comportamento e il loro impatto su un sito web.

1. Crawler generici

I crawler generici sono quelli utilizzati dai principali motori di ricerca per esplorare l’intero web; rientrano in questa categoria Googlebot e Bingbot. Hanno il compito di:

- visitare miliardi di pagine web

- raccogliere contenuti testuali, link e metadati

- aggiornare continuamente l’indice del motore di ricerca

Sono progettati per adattarsi a una grande varietà di siti e per gestire differenti tipi di contenuti (HTML, CSS, JavaScript, PDF, ecc.), e non a caso sono i bot più attivi e costantemente presenti nei file di log dei server web.

2. Crawler verticali o tematici

A differenza di quelli generici, i crawler verticali si concentrano su una specifica tipologia di contenuti. Ne esistono diversi tipi, tra cui:

- crawler per immagini (es. Googlebot-Image)

- crawler per video (es. YouTube Bot)

- crawler per notizie (es. Google News Bot)

- crawler per prodotti e-commerce (es. AmazonBot o Price Intelligence bots)

Questi bot sono specializzati nella raccolta e classificazione di un contenuto specifico e operano con regole diverse da quelle dei crawler generici.

3. Crawler di validazione e analisi

I crawler di validazione vengono utilizzati da strumenti SEO o browser automatizzati per simulare la navigazione di un sito web. Hanno l’obiettivo di:

- verificare la struttura del sito

- testare la corretta risposta HTTP delle pagine

- individuare errori tecnici (link rotti, redirect non funzionanti, contenuti duplicati)

Alcuni fra i più noti sono Screaming Frog SEO Spider, Sitebulb e Lighthouse, e sono fondamentali per effettuare audit tecnici e ottimizzazioni SEO.

4. Crawler aziendali o interni

Molte aziende sviluppano i propri crawler per esigenze specifiche come il monitoraggio del proprio sito web (cambiamenti, performance, link rotti), la raccolta dati dalla concorrenza (price monitoring, comparazione prodotti) o, ancora, la creazione di motori di ricerca interni.

Sono in genere meno invasivi dei crawler pubblici e vengono configurati per non sovraccaricare i server target.

5. Bad Bots

Non tutti i crawler sono benigni. Esistono infatti anche bot malevoli, sviluppati per scopi dannosi di vario tipo, fra cui:

- web scraping: copiano i contenuti dei siti web per ripubblicarli altrove;

- spam bots: inviano commenti o richieste automatiche nei form;

- credential stuffing bots: tentano accessi ripetuti con username e password rubati;

- attacchi DDoS: inviano un numero massivo di richieste per sovraccaricare i server.

Questi bot possono compromettere la sicurezza, le prestazioni e la reputazione di un sito. È fondamentale identificarli e bloccarli tempestivamente.

Principali crawler dei motori di ricerca

Come abbiamo già accennato poco fa, i motori di ricerca utilizzano propri crawler ufficiali per raccogliere informazioni da internet. Questi bot hanno regole di comportamento ben documentate e rispettano (quasi sempre) le indicazioni presenti nel file robots.txt. Vediamo nel dettaglio alcuni fra i principali.

Googlebot

Googlebot è il crawler ufficiale di Google, responsabile della scansione di miliardi di pagine web ogni giorno. Si tratta del bot più attivo e influente sul web, ed è alla base di tutto il processo che permette ai contenuti online di apparire nei risultati di ricerca di Google (SERP).

Esistono due varianti principali di Googlebot, pensate per riflettere il comportamento degli utenti reali su dispositivi diversi:

- Googlebot Desktop, che simula l’esperienza di un utente che visita il sito da computer e che a livello storico è stato per anni il principale riferimento per la scansione;

- Googlebot Smartphone, che invece simula un utente su dispositivo mobile. Dal 2019, con l’introduzione del mobile-first indexing, è diventato il bot predefinito per la maggior parte dei siti.

Entrambi i bot possono essere attivi, ma in genere Google utilizza principalmente la versione mobile. Il suo compito principale è quello di scoprire nuovi contenuti e URL da aggiungere all’indice di Google, eseguendo controlli periodici sulle pagine note per identificare modifiche, aggiornamenti o rimozioni.

Googlebot non scansiona tutto indiscriminatamente. Utilizza algoritmi avanzati per:

- Determinare la priorità delle pagine da visitare, in base a fattori come autorevolezza, frequenza di aggiornamento, link interni/esterni, e importanza nel sito.

- Gestire il crawl budget, ovvero il numero di pagine che può e vuole scansionare in un determinato periodo.

- Adattarsi alla capacità del server, evitando di sovraccaricare siti con risorse limitate.

Le informazioni raccolte vengono poi trasmesse al sistema di indicizzazione di Google, che le utilizza per determinare se (e come) mostrarle nei risultati di ricerca. In pratica, senza Googlebot un sito non potrebbe mai essere trovato su Google.

Caratteristiche tecniche di Googlebot

- Rispetta il file robots.txt

- Supporta JavaScript (con limiti)

- Usa lo user-agent

Googlebot

Per riconoscere Googlebot nei log del server o nei file analytics, bisogna conoscere i suoi user-agent:

- Googlebot Desktop

Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html) - Googlebot Smartphone

Mozilla/5.0 (Linux; Android 6.0.1; Nexus 5X Build/MMB29P) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/41.0.2272.96 Mobile Safari/537.36 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)

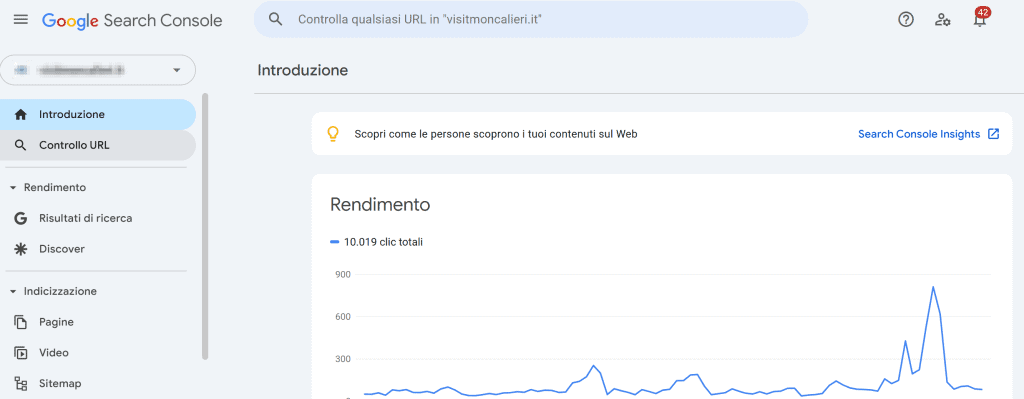

Google fornisce anche un tool di verifica per controllare se un bot è veramente Googlebot (esistono infatti bot falsi che si spacciano per lui). Inoltre, attraverso Google Search Console ti permette di scoprire errori di scansione, URL indicizzati, oltre a suggerimenti di miglioramento.

Come ottimizzare un sito per Googlebot

- Non bloccare accidentalmente Googlebot nel file

robots.txt. Nel caso puoi usare Search Console (sezione Strumento “Controllo URL”) per testare pagine specifiche. - Utilizza una sitemap XML aggiornata per guidare Googlebot verso i contenuti da indicizzare, specialmente in siti grandi o dinamici.

- Garantisci velocità e mobile-friendliness tenendo sempre in alta considerazione i Core Web Vitals. Puoi farti aiutare dastrumenti come PageSpeed Insights e Lighthouse.

- Gestisci correttamente il tag canonical evitando contenuti duplicati e segnalando le versioni preferite delle pagine.

- Offri contenuti di qualità: Googlebot valuta anche la struttura, la pertinenza e l’unicità del contenuto.

- Riduci al minimo gli errori di scansione come pagine 404, redirect errati, loop infiniti, anche attraverso il supporto di Google Search Console.

- Implementa dati strutturati, in quanto migliorano la comprensione del contenuto e l’idoneità per i rich snippet.

- Usa il file robots.txt in modo strategico evitando la scansione di risorse non necessarie (es. pagine di login, filtri di ricerca, cartelle di sistema), ma attenzione a non bloccare asset fondamentali (JS, CSS).

Googlebot è il bot più influente per la visibilità online. Ottimizzare correttamente un sito per il suo comportamento non significa solo farsi trovare, ma anche essere compresi, classificati e valorizzati nei risultati di ricerca.

Bingbot

Bingbot è il crawler ufficiale del motore di ricerca Bing, sviluppato da Microsoft. Ha un funzionamento simile a quello di Googlebot, ma con alcune differenze tecniche, comportamentali e strategiche.

Anche se Bing ha una quota di mercato inferiore rispetto a Google, rimane una fonte di traffico organico rilevante, soprattutto in contesti professionali e aziendali (sistemi Windows, browser Edge, motori di ricerca integrati nei dispositivi Microsoft).

Da un punto di vista operativo possiamo dire che Bingbot svolge per Bing lo stesso lavoro che Googlebot fa per Google, e che abbiamo appena approfondito.

Caratteristiche tecniche di Bingbot

- Simile a Googlebot in termini di comportamento

- Frequenza di scansione generalmente più bassa

- Leggermente meno reattivo ai cambiamenti dei contenuti

Bingbot si identifica con questo user-agent:

Mozilla/5.0 (compatible; bingbot/2.0; +http://www.bing.com/bingbot.htm)

Può inoltre essere riconosciuto anche da user-agent secondari utilizzati per verifiche sulla qualità del contenuto, controlli di rendering e supporto a funzionalità multimediali

Come Google, anche Microsoft mette a disposizione una guida ufficiale e un sistema di verifica IP per controllare se le richieste provengono realmente da Bingbot.

Come ottimizzare un sito per Bingbot

Sebbene Google sia il principale riferimento per la SEO, ottimizzare per Bing può essere vantaggioso, soprattutto per utenti desktop e per le tante integrazioni con servizi Microsoft (es. Cortana, Windows Search, Edge), in uso soprattutto dalle grandi aziende.

Ecco le principali ottimizzazioni da applicare:

- Configura il file robots.txt correttamente: a differenza di Googlebot, Bingbot interpreta

Crawl-delay, utile per siti con risorse limitate. - Utilizza Bing Webmaster Tools, lo strumento equivalente alla Search Console di Google. che permette di inviare sitemap, monitorare errori di scansione, visualizzare backlink e performance organiche.

- Struttura bene la sitemap, importante per l’individuazione rapida dei nuovi contenuti.

- Cura velocità e accessibilità: Bing premia i siti veloci, ben strutturati e compatibili con i browser principali.

- Realizza contenuti leggibili e ottimizzati: Bing apprezza contenuti scritti chiaramente, con buona struttura semantica (H1, H2…), senza eccessivo keyword stuffing. Anche i contenuti multimediali ben ottimizzati (con testo alternativo, titoli, didascalie) sono un vantaggio.

- Alimenta i dati strutturati: Bing supporta Schema.org e utilizza i markup per arricchire i risultati (Rich Snippets).

Ottimizzare Bingbot è un investimento a medio termine che può generare traffico aggiuntivo, lead e visibilità anche al di fuori dell’ecosistema Google.

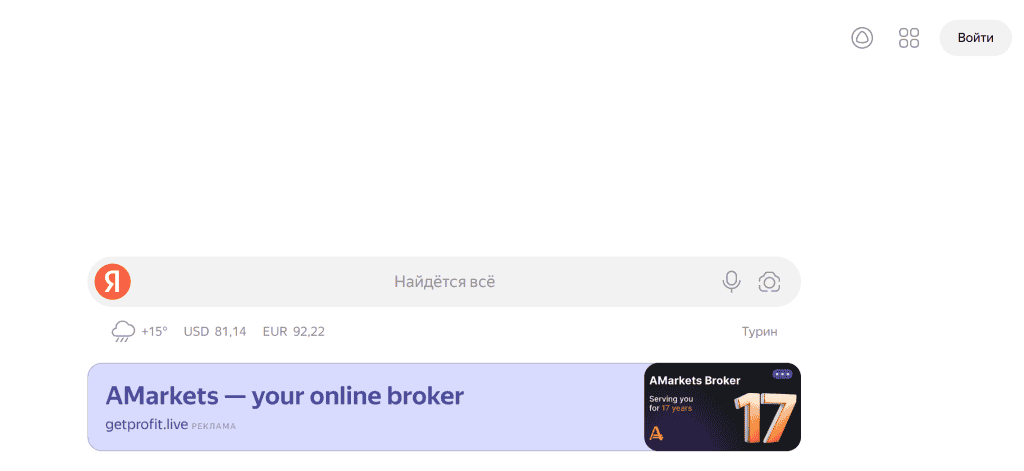

YandexBot

YandexBot è il crawler ufficiale di Yandex, il principale motore di ricerca in Russia e uno dei più utilizzati anche in altri paesi dell’area russofona, come Bielorussia, Kazakistan, Uzbekistan e Ucraina.

I compiti sono i medesimi di Googlebot e Bingbot, ma con l’obiettivo di alimentare l’indice di ricerca di Yandex per fornire risultati coerenti con la lingua, il contesto e le preferenze locali. Yandex ha infatti un’importanza strategica in:

- Russia (quota di mercato superiore al 50% in alcune regioni)

- Mercati dell’ex Unione Sovietica

- Settori in cui la localizzazione linguistica è cruciale (contenuti in cirillico)

Se il tuo sito è rivolto a questi mercati, ottimizzare per YandexBot è essenziale quanto farlo per Google.

Caratteristiche tecniche di YandexBot

- Rispetta pienamente le direttive del file robots.txt, compresi

crawl-delaye specifiche per bot individuali. - Supporta sitemap XML e preferisce sitemap separate per contenuti, immagini, video.

- Riconosce meta tag standard (

robots,noindex,canonical, ecc.), ma può interpretare diversamente alcune implementazioni. - Ha un rendering JavaScript limitato: è consigliabile offrire una versione HTML accessibile anche senza esecuzione JS complessa.

- Dà priorità ai contenuti in lingua russa o in alfabeto cirillico.

Lo user-agent standard di YandexBot è:

Mozilla/5.0 (compatible; YandexBot/3.0; +http://yandex.com/bots)

Dispone inoltre anche di ulteriori bot specializzati, tra cui:

YandexImagesper la ricerca immaginiYandexVideoper la ricerca videoYandexNewsper aggregatori di notizieYandexMediaper contenuti multimediali

Tutti i bot possono essere gestiti tramite il file robots.txt e monitorati nei log del server.

Come ottimizzare un sito per YandexBot

Ecco una serie di accorgimenti tecnici e strategici per migliorare la scansione e l’indicizzazione su Yandex:

- Scrivi contenuti localizzati: scrivi in lingua russa e utilizza encoding UTF-8 e tag

lang="ru"nell’HTML. - Utilizza hosting locali: se possibile, utilizza un server localizzato in Russia o in paesi vicini, e configura correttamente la geolocalizzazione del dominio tramite Yandex Webmaster Tools (es. dominio

.ru, sottocartelle/ru/). - Usa Yandex Webmaster Tools: è l’equivalente di Google Search Console, pensato per Yandex.

- Rispetta le linee guida SEO di Yandex: dai molta attenzione alla qualità editoriale dei contenuti, alla navigabilità e alla pulizia del codice.

- Sviluppa una struttura tecnica chiara: usa URL leggibili, tag semantici e dai una gerarchia logica acontenuti. Preferisci la navigazione testuale ai menu JS dinamici, che YandexBot potrebbe non interpretare correttamente.

- Cura prestazioni e accessibilità: prediligi il rendering server-side, ottimizza la velocità di caricamento ed evita contenuti bloccati da login o interazioni non accessibili al crawler.

YandexBot è un crawler potente e ben strutturato, pensato per servire un pubblico specifico e culturalmente distinto. Ottimizzarlo non richiede solo buone pratiche SEO, ma anche attenzione al contesto linguistico, alla localizzazione geografica e alle preferenze degli utenti russi. Se il tuo sito si rivolge a questo mercato, verificane la compatibilità.

Baiduspider

Baiduspider è il crawler ufficiale di Baidu, il principale motore di ricerca in Cina. Baidu è il punto di riferimento per la ricerca online nel mercato cinese, con una quota di mercato superiore al 70%. Il suo funzionamento è simile a quello di Googlebot, ma presenta caratteristiche specifiche legate alla lingua, alle normative cinesi e al comportamento algoritmico.

Caratteristiche tecniche di Baiduspider

- Supporta robots.txt: rispetta le direttive di base, anche se può comportarsi in modo meno prevedibile rispetto a Googlebot.

- Supporta sitemap XML: Baidu consiglia l’invio tramite la Baidu Webmaster Platform.

- Comprensione limitata di JavaScript: meglio servire contenuti essenziali in HTML puro.

- Favorisce contenuti in lingua cinese: scritti in cinese semplificato (ZH-CN).

- Riconosce tag meta e canonical: ma potrebbe non applicarli sempre come previsto.

Il suo user-agent standard è:

Mozilla/5.0 (compatible; Baiduspider/2.0; +http://www.baidu.com/search/spider.html)

Esistono inoltre delle varianti specializzate:

Baiduspider-image: per le immaginiBaiduspider-video: per i videoBaiduspider-news: per le notizie

Come ottimizzare un sito per Baiduspider

- Utilizza hosting cinese o con server vicini alla Cina.

- Ottieni l’ICP license (Internet Content Provider) necessaria per i siti che vogliono essere pienamente indicizzati in Cina.

- Scrivi contenuti in lingua cinese, con encoding UTF-8 o GB2312.

- Evita servizi bloccati in Cina (es. Google Fonts, YouTube, Facebook scripts) che possono rallentare o bloccare la scansione.

- Registrati alla Baidu Webmaster Tools per inviare sitemap, monitorare errori, rimuovere URL e analizzare traffico organico.

Per l’ottimizzazione internazionale, richiede accorgimenti specifici (hosting locale, contenuti in cinese, ICP license).

DuckDuckBot

È il crawler utilizzato da DuckDuckGo, noto per la sua attenzione alla privacy degli utenti. DuckDuckGo non traccia le ricerche personali e non personalizza i risultati, a differenza di Google.

DuckDuckBot raccoglie contenuti pubblicamente accessibili per arricchire il proprio indice, ma non si basa solo sul crawling diretto: integra anche i risultati da Bing, Wikipedia, Yelp e altre fonti.

Caratteristiche tecniche di DuckDuckBot

- Rispetta robots.txt e meta tag

robots. - Scansione meno frequente rispetto a Googlebot e Bingbot.

- Non supporta JavaScript avanzato: meglio fornire contenuti statici e accessibili senza rendering JS.

- Evita tracciamento: il crawler e il motore rispettano la privacy in modo rigoroso, non leggono cookie di terze parti.

- Combina dati da fonti multiple (incluso Bing)

- User-agent:

DuckDuckBot/1.0; (+http://duckduckgo.com/duckduckbot.html)

Come ottimizzare un sito per DuckDuckBot

- Verifica che il sito sia scansionabile senza necessità di eseguire JS complesso.

- Assicurati che i contenuti principali siano testuali, ben strutturati e accessibili.

- Non sono richiesti markup o licenze particolari, ma è utile adottare dati strutturati per migliorare la comprensione del contenuto.

Non esiste uno strumento equivalente a Google Search Console, ma puoi monitorare DuckDuckBot tramite l’analisi dei log server.

Applebot

Applebot è il crawler sviluppato da Apple Inc. ed è utilizzato per raccogliere informazioni da siti web con lo scopo di alimentare i suoi servizi di ricerca, assistenza vocale e suggerimenti contestuali. La sua importanza è legata al fatto che si occupa di raccogliere dati dal web per supportare i seguenti strumenti:

- Siri per fornire risposte vocali alle domande degli utenti iOS/macOS;

- ricerca Spotlight per mostrare risultati web quando si usa la ricerca interna su dispositivi Apple;

- Safari per proporre contenuti utili o pertinenti mentre si digita nella barra degli indirizzi del browser Safari;

- Risultati Siri Suggestions personalizzati, cioè per generare consigli in base al comportamento e agli interessi dell’utente.

Nonostante Apple non gestisca un motore di ricerca “classico” come Google, la sua raccolta dati ha obiettivi simili: fornire risultati rilevanti e aggiornati in ambienti digitali controllati da Apple.

Caratteristiche tecniche di Applebot

- User-agent ufficiale:

Mozilla/5.0 (compatible; Applebot/0.1; +http://www.apple.com/go/applebot) - Rispetta robots.txt: Applebot segue le direttive impostate nel file

robots.txt. Puoi usarlo per consentire o bloccare l’accesso a specifiche sezioni del sito. - Supporta meta tag robots: Oltre al

robots.txt, Applebot interpreta correttamente i tagrobotsinseriti nel codice HTML (es.noindex,nofollow,noarchive). - Supporta il protocollo HTTP/HTTPS

Come ottimizzare un sito per Applebot

Anche se meno influente rispetto a Googlebot, è utile assicurarsi che Applebot possa accedere e comprendere correttamente i tuoi contenuti:

- Non bloccare Applebot nel robots.txt (a meno che tu non voglia escluderlo esplicitamente).

- Verifica la compatibilità mobile del sito: Apple prioritizza contenuti ottimizzati per dispositivi mobili.

- Utilizza dati strutturati (Schema.org) per migliorare l’interpretazione dei contenuti.

- Assicurati che le pagine siano accessibili senza login o interazioni complesse (Applebot non può gestire contenuti protetti).

- Fornisci contenuti chiari, sintetici e aggiornati: Siri, ad esempio, preferisce risposte brevi e dirette.

Applebot è un crawler sempre più rilevante nell’ecosistema digitale moderno, soprattutto in relazione ai contenuti vocali, contestuali e su dispositivi mobili. Anche se non incide direttamente sul ranking nei motori di ricerca tradizionali, ottimizzare il sito per Applebot migliora la visibilità nei dispositivi Apple e può contribuire a un’esperienza utente più ricca e personalizzata.

Crawler | Motore / Azienda | User-agent | Mobile-first | Supporto JS | Webmaster Tool | Mercato |

|---|---|---|---|---|---|---|

Googlebot | Google | Googlebot/2.1 | Sì | Avanzato | Google Search Console | Globale |

Bingbot | Microsoft Bing | bingbot/2.0 | Parziale | Limitato | Bing Webmaster Tools | Globale, USA/UK |

YandexBot | Yandex | YandexBot/3.0 | No | Limitato | Yandex Webmaster Tools | Russia, paesi russofoni |

Baiduspider | Baidu | Baiduspider/2.0 | No | Scarso | Baidu Webmaster Tools | Cina |

DuckDuckBot | DuckDuckGo | DuckDuckBot/1.0 | Limitato | No | Nessuno | Globale |

Applebot | Apple | Applebot/0.1 | ✅ Sì | ⚠️ Limitato | Nessuno | Ecosistema Apple |

Crawler e SEO in dettaglio

Il comportamento dei crawler ha un impatto diretto sulla visibilità organica di un sito nei risultati dei motori di ricerca. Ma perché il crawling è così fondamentale? Perché se una pagina non viene scansionata, non può essere indicizzata e, di conseguenza, non comparirà mai nei risultati di ricerca.

Ci sono alcuni fattori che influenzano la frequenza di scansione:

- Autorità del dominio: i siti con maggiore trust e backlink di qualità vengono visitati più frequentemente.

- Frequenza di aggiornamento dei contenuti: un blog aggiornato ogni giorno viene scansionato più spesso di un sito statico.

- Struttura dei link interni: una rete di collegamenti chiara e gerarchica aiuta i bot a scoprire e raggiungere tutte le pagine.

- Prestazioni del sito: tempi di caricamento lenti riducono il crawl budget e penalizzano l’efficienza dei bot.

- Errori tecnici: pagine con errori 404, redirect non validi o contenuti duplicati possono disorientare i crawler e compromettere la scansione.

Un sito web ben progettato non solo offre una buona esperienza utente, ma facilita anche la vita ai crawler. L’ottimizzazione per i bot di ricerca è parte integrante della SEO tecnica e può fare la differenza tra una pagina ben posizionata e una ignorata.

Nei paragrafi precedenti abbiamo visto una sintesi dei principali aspetti tecnici che ciascun crawler specifico tiene in maggiore considerazione e che possono aiutarti in un’ottimizzazione puntuale per ogni motore di ricerca. Qui invece vogliamo soffermarci più in generale su ogni attività, fornendoti qualche dettaglio in più.

File robots.txt

Il file robots.txt, posizionato nella root del sito (tuosito.it/robots.txt), indica ai crawler quali aree del sito devono o non devono essere esplorate.

Esempio di base:

User-agent: *

Disallow: /admin/

Questo file non impedisce l’indicizzazione, ma solo la scansione. È utile per:

- Proteggere risorse non pubbliche (es. pagina di amministrazione, come nell’esempio di cui sopra)

- Evitare lo spreco di crawl budget

- Evitare la duplicazione di contenuti tecnici

Attenzione: errori in questo file possono bloccare involontariamente sezioni importanti del sito.

Sitemap XML

La sitemap è un file che elenca le pagine più importanti del sito, spesso situato su tuosito.it/sitemap.xml.

La sitemap aiuta i motori a scoprire nuove pagine, ma non solo. Nella sitemap infatti sono segnalati anche tutti gli ultimi aggiornamenti delle pagine e, se ben organizzata, può fornire anche l’elenco di immagini, video, categorie e altre tipologie di contenuto.

Va inviata attraverso Google Search Console o altri strumenti equivalenti per Bing, Yandex, ecc., oppure utilizzando plugin WordPress dedicati.

Link interni coerenti

I crawler seguono i link per esplorare un sito, e osservano anche gli anchor text a cui sono abbinate i vari URL. Una buona architettura di link interni permette di diffondere l’autorità di un contenuto (link juice) su più pagine, indicare gerarchia e priorità delle pagine ed evitare contenuti “orfani”, vale a dire non collegati con nessun altra pagina.

Non dimenticare poi di curare la struttura gerarchica del tuo sito. Un sito ben organizzato è più facile da comprendere per gli utenti e per i crawler. Le sezioni principali devono essere raggiungibili in massimo 3 click dalla home page.

Esempio:

Home > Blog > SEO > Crawler

Contenuti unici e aggiornati

I motori di ricerca premiano i siti con contenuti freschi, utili e originali, e maggiore sarà l’aggiornamento più alto sarà l’interesse dei crawler per loro. Ecco perché i bot valutano la frequenza di aggiornamento, così da adattare il proprio ciclo di scansione di conseguenza.

Tag canonical

Serve a segnalare qual è la versione “ufficiale” di una pagina in caso di contenuti simili o duplicati.

Esempio:

<link rel="canonical" href="https://www.tuosito.it/articolo-originale/">

Ottimizzazione delle performance

I crawler preferiscono siti veloci e mobile-friendly. Usa strumenti come Google PageSpeed Insights o GTmetrix per migliorare tempo di caricamento e responsività mobile.

Strumenti per monitorare i crawler

Per capire come i crawler interagiscono con il tuo sito, è fondamentale utilizzare strumenti di analisi e monitoraggio. Questi tool aiutano a diagnosticare problemi, migliorare la scansione e ottimizzare l’indicizzazione.

- Google Search Console, lo strumento ufficiale di Google per i webmaster. Ti consente di verificare se una pagina è indicizzata, e se non lo è puoi richiedere l’indicizzazione manuale. Qui puoi inoltre visualizzare statistiche di scansione ed eventuali errori (404, redirect, noindex, ecc.)

- Log file del server, in cui troverai un registro completo di tutte le richieste HTTP al sito, comprese quelle dei bot. Analizzandoli è possibile vedere quali crawler visitano il sito, quali URL vengono richiesti e identificare eventuali picchi di traffico anomalo da bot. A tal proposito alcuni strumenti utili come Screaming Frog Log File Analyser, GoAccess o Awstats.

- Screaming Frog SEO Spider è uno strumento desktop che simula l’azione di un crawler e verifica che non ci siano anomalie. Viene spesso utilizzato per effettuare audit tecnici SEO accurati.

- Altri strumenti SEO professionali come Ahrefs, SEMrush e Moz che offrono una panoramica avanzata delle attività SEO, tra cui:

- Crawler proprietari per simulare il comportamento dei motori;

- Audit tecnico con report su errori, avvisi e suggerimenti;

- Analisi dei backlink, keyword e concorrenza.

Crawler e sicurezza del sito

Non tutti i bot sono amichevoli. Alcuni possono causare danni seri, sia in termini di sicurezza sia in termini di prestazioni. Fra le principali minacce ti segnaliamo:

- bot di scraping: copiano contenuti per ripubblicarli illegalmente;

- spam bot: riempiono i moduli di contatto con messaggi indesiderati;

- attacchi DDoS: sovraccaricano i server con migliaia di richieste simultanee;

- bot per attacchi brute force: tentano l’accesso a pannelli di amministrazione tramite combinazioni di username/password.

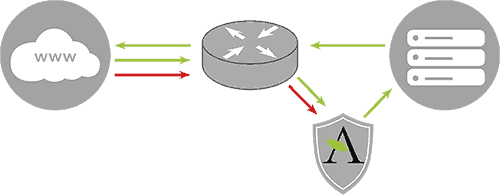

Bilanciare accessibilità e sicurezza è essenziale: non bisogna bloccare i bot buoni, ma nemmeno lasciare porte aperte a quelli dannosi. Ci sono diversi modi per proteggersi dai crawler pericolosi:

- bloccare i crawler sospetti tramite

robots.txt(solo se il bot lo rispetta), file.htaccesso firewall a livello server; - limitare il numero di richieste per IP usando moduli Apache/Nginx o strumenti come fail2ban;

- usare CAPTCHA nei moduli per evitare l’invio automatico di form da parte di bot

- monitorare i log per rilevare picchi anomali di traffico o accessi non autorizzati

- utilizzare WAF (Web Application Firewall) come Cloudflare, Sucuri o Wordfence (per WordPress).

Crawler e hosting: impatti e considerazioni

L’attività dei crawler influisce direttamente sull’infrastruttura del sito. Ogni visita di un bot genera richieste HTTP che consumano risorse server.

Se più bot visitano il sito contemporaneamente, può verificarsi un sovraccarico del server e un consumo eccessivo di CPU e RAM. Grandi picchi di traffico possono causare rallentamenti o, nei casi peggiori, errori 500.

Al di là dei crawler, se prevedi che il tuo sia di grandi dimensioni, ti consigliamo di scegliere uno dei nostri server VPS o server dedicati e attivare una CDN (nel nostro caso potrai contare su CloudFlare) per distribuire il carico tra server in tutto il mondo. Valuta inoltre di attivare un sistema di caching avanzato per ridurre il carico delle pagine statiche sui bot e sugli utenti.

Conclusioni

I crawler sono il motore silenzioso che alimenta i motori di ricerca. Comprendere come funzionano e come interagiscono con il tuo sito è fondamentale per ottenere visibilità online.

Ottimizzare un sito per i crawler non significa “ingannare” i motori di ricerca quanto, piuttosto, rendere i contenuti più accessibili, comprensibili e veloci da esplorare. Un sito ben strutturato, veloce, sicuro e informativo sarà naturalmente premiato nella SERP.

Com’è il tuo rapporto con i crawler e l’ottimizzazione del tuo sito? Raccontaci la tua esperienza nei commenti!

Lascia un commento